Comment a été ce contenu ?

- Apprendre

- Comment Proto donne vie à des périphéries de pointe grâce à Amazon Bedrock

Comment Proto donne vie à des périphéries de pointe grâce à Amazon Bedrock

.png)

En Australie, un patient a besoin de soins spécialisés d'urgence dispensés par un médecin britannique. Une entreprise de robotique doit présenter sa dernière invention à des investisseurs potentiels sans avoir à transporter des machines. Un nouvel hôtel souhaite offrir à ses clients une expérience haut de gamme. Proto permet tout cela et bien plus encore, grâce à des hologrammes alimentés par l'IA générative.

Proto exploite l'intelligence artificielle générative (IA) pour créer des avatars réalistes qui sont transmis à une impressionnante machine holographique de 7 pieds, où ils peuvent engager une conversation authentique, fournir des informations, participer à des tâches et se divertir. Ils sont déjà actifs dans des secteurs tels que la publicité et la vente au détail, le divertissement, les transports, l'hôtellerie, l'éducation, la formation et les soins de santé, au service des entreprises du Fortune 500 et de certaines des équipes sportives et célébrités les plus connues au monde.

Ainsi, ce patient nécessitant des soins urgents peut être évalué à distance par un spécialiste situé à des milliers de kilomètres. L'entreprise de robotique peut présenter son dernier produit sans avoir à gérer les coûts et la complexité liés à l'exportation de kits coûteux. Et l'hôtel peut accueillir ses clients avec des chatbots grandeur nature et fournir un service de conciergerie numérique personnalisé pour se démarquer de la concurrence.

Chacun de ces cas d'utilisation présente des caractéristiques (par exemple, coûts, latence, précision) qui nécessitent de choisir un modèle de fondation (FM) plutôt qu'un autre. Proto avait donc besoin d'une solution facilitant l'expérimentation, le test et l'adaptation d'avatars améliorés par IA en fonction de leur cas d'utilisation particulier. La migration vers Amazon Bedrock a fourni cette solution, permettant à Proto d'accéder à un large choix de FM qui peuvent être évalués, expérimentés, déployés et personnalisés en toute simplicité.

Améliorer et rationaliser avec Amazon Bedrock

Bien qu'il soit un leader dans son domaine, la demande du marché pour une latence plus faible, un plus grand réalisme et une plus grande précision dans les engagements a incité Proto à rechercher un moyen d'améliorer ses avatars d'IA. Les avatars de Proto peuvent être diffusés à des milliers de spectateurs ou personnalisés pour une seule personne, relayer des informations en temps réel ou proposer une formation de haut niveau. Quels que soient leur objectif ou leur secteur d'activité, ils doivent fournir un niveau sophistiqué de réalisme, de précision et de sécurité tout en proposant un personnage d'avatar adapté au cas d'utilisation. Par exemple, un concierge d'hôtel virtuel aurait besoin de réglages spécifiques pour améliorer l'expérience des clients, tandis qu'un professeur d'art virtuel a besoin de flexibilité pour transformer le langage en images.

Proto souhaitait également rationaliser le processus de création et de gestion des applications. Cela avait été compliqué par l'utilisation de différents services et outils par le passé par Proto : l'entreprise utilisait une suite de services AWS mais créait avec un autre fournisseur.

L'IA générative est un domaine en évolution rapide, où les acteurs exigeants continuent d'innover dans leurs produits et de servir au mieux leurs clients. Cela nécessite du temps et des ressources humaines, soutenus par des outils flexibles qui peuvent vous aider à soulever des objets lourds. Fragmenté entre plusieurs solutions, l'environnement existant de Proto a rendu difficile la gestion des services AWS existants et le déploiement de nouveaux services. Grâce à une approche basée sur Amazon BedRock, Proto est en mesure d'itérer en permanence sur ses avatars et de les adapter en fonction des interactions des utilisateurs en temps réel. Cela permet de s'assurer que le contenu est toujours adapté à un contexte donné. Par exemple, Proto peut décider sur le moment si un certain sujet est approprié ou non et établir des directives, appelées barrières de protection, au milieu de l'interaction pour garantir la sécurité de ces engagements.

Ces facteurs, ainsi que la nécessité de disposer des derniers outils d'IA générative, ont incité Proto à décider de migrer vers Anthropic's Claude sur Amazon Bedrock. Cela a permis à l'entreprise d'améliorer ses avatars d'IA et les processus utilisés pour les créer.

Pourquoi Amazon Bedrock ?

Amazon Bedrock est un service entièrement géré qui propose un choix de modèles de base hautement performants via une API unique, ainsi qu'un large éventail de fonctionnalités pour aider les start-ups à créer des applications d'IA génératives garantissant sécurité, confidentialité et responsabilité.

Amazon Bedrock permet aux utilisateurs d'expérimenter et d'évaluer facilement les meilleurs FM pour divers cas d'utilisation, de les personnaliser en privé avec leurs propres données à l'aide de techniques telles que le réglage fin et la génération à enrichissement contextuel (RAG), et de créer des agents qui exécutent des tâches à l'aide de leurs propres systèmes d'entreprise et sources de données.

Amazon Bedrock est également sans serveur, ce qui signifie que les start-ups n'ont pas à gérer d'infrastructure et peuvent intégrer et déployer en toute sécurité des fonctionnalités d'IA génératives dans des applications à l'aide des services AWS qu'elles connaissent déjà.

Les mécanismes de la migration

Proto a migré vers Amazon Bedrock et a choisi Anthropic’s Claude Instant, une émission FM disponible sur Amazon Bedrock, pour présenter un avatar conversationnel lors d'une grande conférence. Elle a affiné ce modèle pour optimiser son avatar d'IA, en mettant en place des barrières de protection pour garantir que les interactions étaient adaptées au cadre, au public et au contexte.

Amazon Bedrock a permis à Proto de tester les performances de différents FM avant de passer à l'étape suivante du développement, ce qui lui a permis de choisir la solution la plus rentable pour chaque cas d'utilisation. Ce processus était simple et n'a donc pas eu d'impact sur le flux de travail ou les pipelines de déploiement, deux éléments essentiels pour les start-ups qui souhaitent rester à la pointe du développement de l'IA. Comme l'explique Raffi Kryszek, directeur des produits et de l'IA chez Proto, « Amazon Bedrock nous a permis de tester les performances de notre avatar lorsqu'il provenait de différents modèles fondamentaux en ne modifiant qu'une seule ligne de code ».

Proto a également déployé Amazon Polly, un service cloud qui convertit le texte en une parole réaliste, et Amazon Transcribe, un service de reconnaissance vocale qui convertit automatiquement la parole en texte. Cela leur donne la flexibilité nécessaire pour adapter leur solution pour faciliter la conversation dans différentes langues telles que le japonais, le coréen et l'espagnol.

Outre la gamme de services proposés, les fonctionnalités spécifiques d'Amazon Bedrock ont permis à Proto de s'adapter rapidement et de tirer parti des derniers outils d'IA générative au fur et à mesure de sa croissance.

L'essentiel de la migration était axé sur la reconfiguration des API. Cela a nécessité une analyse approfondie du fonctionnement interne des deux systèmes afin de garantir une communication fluide entre l'interface utilisateur de Proto et les services Amazon Bedrock. L'équipe technique de Proto a pu rapidement refactoriser son code à l'aide des API Amazon Bedrock et a utilisé la technique de mise en forme rapide spécifique de Claude pour améliorer la qualité des réponses des avatars.

Cette migration a marqué un tournant dans l'approche de Proto en matière de personnalisation des paramètres d'inférence, selon laquelle les paramètres sont ajustés pour contrôler les réponses du modèle. Le processus impliquait une utilisation complète des fonctionnalités de l'API d'Amazon Bedrock, l'équipe tirant parti de ses nombreuses options de configuration pour affiner la génération de réponses. Cela incluait les réglages de température et de K maximum.

Une meilleure gestion de la température permet un contrôle plus nuancé de la créativité par rapport à la fidélité. Pour un avatar d'IA informatif, tel que celui utilisé par une entreprise de santé pour fournir des informations médicales, Proto peut opter pour un réglage de température plus bas, en donnant la priorité à la précision et à la pertinence. Le fait de pouvoir ajuster la température de cette manière signifie que Proto peut adopter une approche plus nuancée pour répondre aux besoins des différents clients déployant différents types d'avatars d'IA. Il est important de noter que son équipe peut le faire bien plus rapidement et plus facilement que par le passé, car Amazon Bedrock réduit les exigences techniques imposées à ses utilisateurs.

Proto peut également être plus précis dans le processus d'étalonnage lorsqu'il s'agit de contrôler les meilleurs paramètres K. Tout comme la température, le paramètre top k est une autre catégorie de paramètres d'inférence qui peuvent être ajustés pour limiter ou influencer la réponse du modèle.

Top K est le nombre d'options les plus probables qu'un modèle prend en compte pour le jeton suivant d'une séquence. Il peut s'agir du mot suivant d'une phrase, ce qui rend le réglage top-k essentiel pour contrôler la génération de texte et garantir la cohérence et l'exactitude du texte. En abaissant cette valeur, la taille du pool d'options que le modèle peut choisir est réduite aux options les plus probables. Cela pourrait être utilisé pour des résultats plus prévisibles et ciblés, tels que la documentation technique. Une valeur plus élevée augmente la taille de ce pool et permet au modèle de prendre en compte les options les moins probables. Cela pourrait être utilisé pour la narration créative, où une plus grande variété de choix de mots est souhaitable pour améliorer la richesse et l'imprévisibilité du récit.

L'exploitation de cette fonctionnalité a permis à Proto d'optimiser les performances et la qualité en personnalisant soigneusement les sorties pour les différents avatars d'IA, en fonction de leur cas d'utilisation.

Enfin, Proto a bénéficié des capacités d'ingénierie de requête de Claude. L'équipe a développé un ensemble de bonnes pratiques pour le réglage des paramètres, améliorant ainsi la réactivité et la pertinence de l'IA. Cette approche personnalisée souligne l'importance de comprendre les capacités et les contraintes du modèle d'IA sous-jacent, afin de s'assurer que les développeurs peuvent exploiter pleinement la technologie pour répondre aux exigences spécifiques de l'avatar d'IA qu'ils déploient, de son public et de ses besoins.

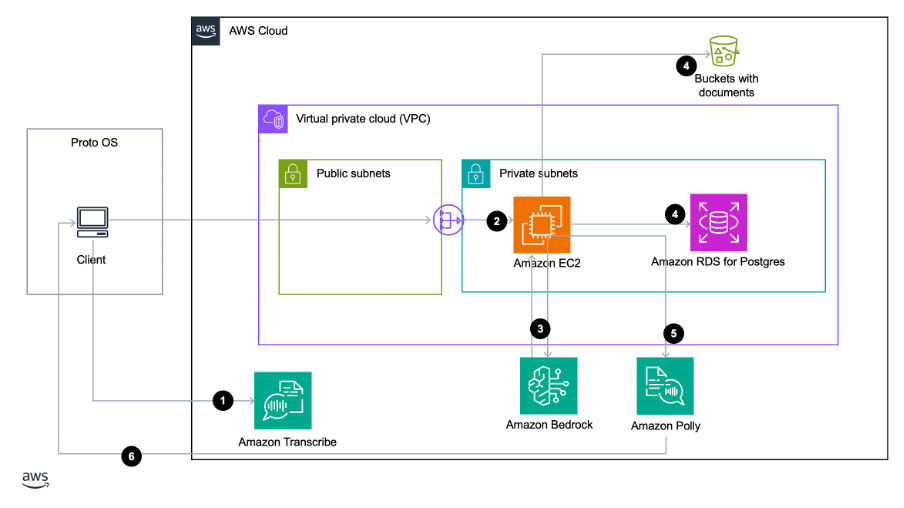

Implémentation de l'architecture

L'utilisation d'Amazon Bedrock a permis à Proto d'améliorer la façon dont les avatars IA répondent aux requêtes des utilisateurs. L'architecture commence lorsqu'un utilisateur pose une question qui est ensuite dirigée vers Amazon Bedrock. Le processus RAG fusionne les entrées des utilisateurs en temps réel avec des informations approfondies provenant des données propriétaires de Proto ainsi que de référentiels de données externes. Cela permet de générer des invites à la fois précises et pertinentes, ce qui donne lieu à une conversation personnalisée en fonction de l'utilisateur qui pose la requête.

Proto a pu choisir la taille des segments des intégrations, ce qui permet d'utiliser plus ou moins d'informations dans les réponses fournies par ses avatars d'IA. Les intégrations plus petites sont idéales pour des applications telles qu'un assistant personnel, car elles permettent d'ajouter de nombreux souvenirs à l'invite. En revanche, les intégrations plus grandes sont plus utiles lorsque les documents sont séparés de manière à ne pas disperser les informations.

Une fois que l'invite est augmentée, elle est traitée par une sélection de modèles d'IA avancés, dont Claude. Dans chaque application Proto, un identifiant d'avatar unique dirige ces requêtes, permettant des réponses précises et contextuelles en consultant la base de données appropriée.

Les réponses sont ensuite envoyées à Amazon Polly pour s'assurer que chaque mot prononcé par ses avatars est non seulement représenté visuellement grâce à une synchronisation labiale précise, mais également transmis à grande vitesse, ce qui permet d'obtenir des réponses fluides à la fois visuellement et interactivement. L'avatar de l'IA ressemble davantage à un humain lorsqu'il parle à son utilisateur, et la conversation se déroule le plus possible en temps réel.

Conclusion

Grâce à la migration, Proto utilise désormais les outils d'IA générative les plus avancés pour fournir les applications d'IA générative les plus innovantes à ses clients. En tant que service entièrement géré, le passage à Amazon Bedrock a permis à l'équipe de Proto de ne pas perdre de temps à réarchitecturer ses solutions pour prendre en charge plusieurs modèles de base. L'équipe est maintenant libérée pour se concentrer sur ce qui compte : construire, mettre à l'échelle et optimiser les produits pour s'adapter aux besoins de leurs utilisateurs finaux - et faire croître leur start-up en conséquence.

L'optimisation de ces produits est déjà claire : en se concentrant sur la reconfiguration des API dans le cadre de la migration gérée, Proto a amélioré les capacités de ses avatars, leur permettant de rester à la pointe de la technologie d'IA conversationnelle. Les adapter aux différents secteurs, et à la rapidité avec laquelle elle peut le faire, permet à l'entreprise de mieux servir une large clientèle et d'étendre sa portée à de multiples secteurs à un rythme compétitif.

La migration des charges de travail et des applications vers AWS n'est que le début. Proto est allé encore plus loin en adaptant et en tirant parti des capacités d'IA générative d'AWS. Elle les utilise désormais dans l'ensemble de son flux de travail : qu'il s'agisse de modifier des outils conçus par des leaders du domaine ou de déployer la technologie qui crée des engagements significatifs pour ses clients.

En migrant vers AWS, elle a allégé la charge (technique) de son équipe tout en développant ses capacités créatives, et elle crée, fait évoluer et déploie plus facilement ses propres applications d'IA de génération garantissant sécurité, confidentialité et responsabilité. Que vous soyez une start-up qui souhaite commencer son parcours avec l'IA générative, ou que vous souhaitiez optimiser et améliorer votre flux de travail et vos produits actuels, le programme AWS Migration Acceleration peut vous aider à explorer les options qui s'offrent à vous et à en savoir plus sur la manière dont Amazon Bedrock peut vous aider.

Avec la contribution de Shaun Wang et Tony Gabriel Silva

Aymen Saidi

Aymen is a Principal Solutions Architect in the AWS EC2 team, where he specializes in cloud transformation, service automation, network analytics, and 5G architecture. He’s passionate about developing new capabilities for customers to help them be at the forefront of emerging technologies. In particular, Aymen enjoys exploring applications of AI/ML to drive greater automation, efficiency, and insights. By leveraging AWS's AI/ML services, he works with customers on innovative solutions that utilize these advanced techniques to transform their network and business operations.

Hrushikesh Gangur

Hrushikesh Gangur est l'un des principaux architectes de solutions pour les startups d'intelligence artificielle et de machine learning. Il possède une expertise à la fois dans le machine learning et les services de mise en réseau d’AWS. Il aide les startups à créer une IA générative, des véhicules autonomes et des plateformes de ML afin de leur permettre de gérer leur activité de manière efficiente et efficace sur AWS.

Nolan Cassidy

Nolan Cassidy is the Lead R & D Engineer at Proto Hologram, specializing in holographic spatial technology. His pioneering work integrates AI and advanced communication systems to develop low-latency, highly interactive experiences, enabling users to feel present in one location while physically being in another.

Comment a été ce contenu ?