Com'era questo contenuto?

- Scopri

- In che modo Patronus AI aiuta le aziende a rafforzare la loro fiducia nell'IA generativa

In che modo Patronus AI aiuta le aziende a rafforzare la loro fiducia nell'IA generativa

Negli ultimi anni, e soprattutto dal lancio di ChatGPT nel 2022, il potenziale di trasformazione dell'intelligenza artificiale (IA) generativa è diventato innegabile per le organizzazioni di tutte le dimensioni e in un'ampia gamma di settori. La prossima ondata di adozione è già iniziata, con le aziende che si affrettano ad adottare strumenti di IA generativa per aumentare l'efficienza e migliorare le esperienze dei clienti. Un rapporto McKinsey del 2023 ha stimato che l'IA generativa potrebbe aggiungere l'equivalente di 2,6 trilioni di dollari a 4,4 trilioni di dollari di valore all'economia globale all'anno, aumentando l'impatto economico complessivo dell'IA di circa il 15-40%, mentre l'ultimo sondaggio del CEO di IBM ha rilevato che il 50% degli intervistati stava già integrando l'IA generativa nei propri prodotti e servizi.

Man mano che l'IA generativa diventa mainstream, tuttavia, i clienti e le aziende esprimono sempre più preoccupazione per la sua attendibilità e affidabilità. Inoltre, spesso non è chiaro perché determinati input portino a determinati output e ciò rende difficile per le aziende valutare i risultati della loro IA generativa. Patronus AI, una società fondata dagli esperti di machine learning (ML) Anand Kannappan e Rebecca Qian, ha deciso di affrontare questo problema. Con la sua piattaforma di valutazione e sicurezza automatizzata basata sull'intelligenza artificiale, Patronus aiuta i suoi clienti a utilizzare modelli linguistici di grandi dimensioni (LLM) in modo sicuro e responsabile, riducendo al minimo il rischio di errori. L'obiettivo della startup è rendere i modelli di intelligenza artificiale più affidabili e più utilizzabili. "Questa è diventata la grande domanda dell'anno scorso. Ogni azienda desidera utilizzare modelli linguistici, ma è preoccupata per i rischi e anche solo per l'affidabilità del modo in cui funzionano, soprattutto per i loro casi d'uso molto specifici", spiega Anand. "La nostra missione è aumentare la fiducia delle aziende nell'IA generativa".

Sfruttare i vantaggi e gestire i rischi dell'IA generativa

L'IA generativa è un tipo di intelligenza artificiale che utilizza il machine learning per generare nuovi dati simili a quelli su cui è stata addestrata. Apprendendo i modelli e la struttura dei set di dati di input, l'IA generativa produce contenuti originali: immagini, testo e persino righe di codice. Le applicazioni di IA generativa sono basate su modelli ML che sono stati pre-addestrati su grandi quantità di dati, in particolare LLM formati su trilioni di parole in una serie di attività in linguaggio naturale.

I potenziali vantaggi aziendali sono tantissimi. Le aziende hanno dimostrato interesse a utilizzare gli LLM per sfruttare i propri dati interni attraverso il recupero, produrre promemoria e presentazioni, migliorare l'assistenza automatica via chat e completare automaticamente la generazione di codice nello sviluppo del software. Anand indica anche l'intera gamma di altri casi d'uso che non sono ancora stati realizzati. "Ci sono molti settori diversi che l'IA generativa non ha ancora rivoluzionato. Siamo davvero solo all'inizio di tutto ciò che stiamo vedendo finora".

Man mano che le organizzazioni considerano di espandere il loro uso dell'IA generativa, la questione dell'affidabilità diventa più urgente. Gli utenti vogliono assicurarsi che i loro risultati siano conformi alle normative e alle politiche aziendali evitando al contempo risultati pericolosi o illegali. "Per le aziende e le imprese più grandi, specialmente nei settori regolamentati", spiega Anand, "ci sono molti scenari cruciali in cui desiderano utilizzare l'IA generativa, ma sono preoccupati che se si verifica un errore, ciò metta a rischio la loro reputazione e persino i propri clienti".

Patronus aiuta i clienti a gestire questi rischi e ad aumentare la fiducia nell'IA generativa migliorando la capacità di misurare, analizzare e sperimentare le prestazioni dei modelli in questione. "Si tratta davvero di assicurarsi che, indipendentemente dal modo in cui il sistema è stato sviluppato, il test e la valutazione complessivi di tutto siano molto solidi e standardizzati", afferma Anand. «Ed è proprio questo che manca in questo momento: tutti vogliono usare modelli linguistici, ma non esiste un framework realmente stabilito o standardizzato su come testarli correttamente in un modo molto più scientifico».

Miglioramento dell'affidabilità e delle prestazioni

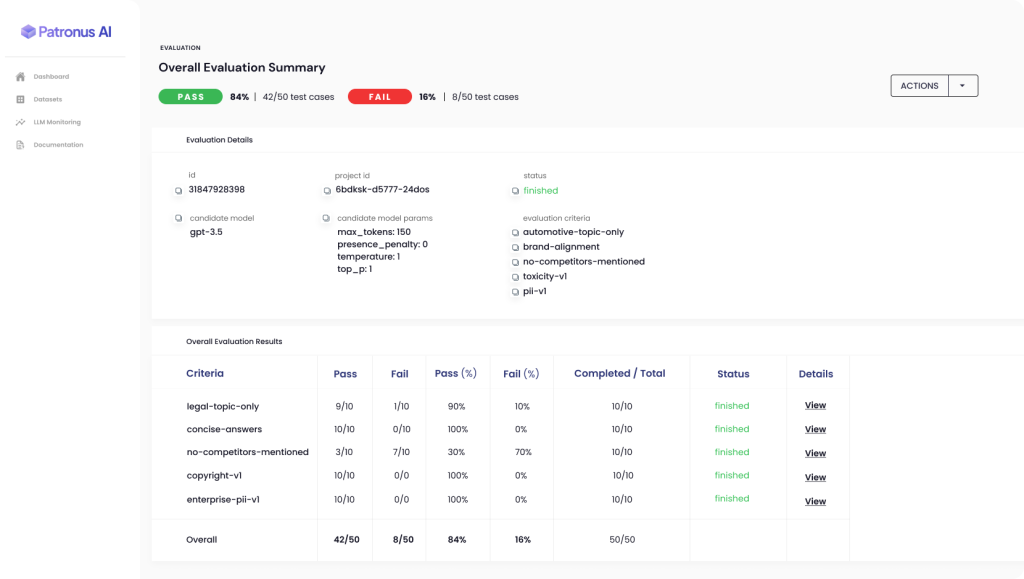

La piattaforma automatizzata Patronus consente ai clienti di valutare e confrontare le prestazioni di diversi LLM in scenari reali, riducendo così il rischio di risultati indesiderati. Patronus utilizza nuove tecniche di machine learning per aiutare i clienti a generare automaticamente suite di test contraddittorie e a valutare e confrontare le prestazioni dei modelli linguistici in base alla tassonomia di criteri proprietaria di Patronus. Ad esempio, il set di dati FinanceBench è il primo benchmark del settore per le prestazioni degli LLM su questioni finanziarie.

"Tutto ciò che facciamo in Patronus è focalizzato sull'aiutare le aziende a rilevare gli errori dei modelli linguistici in un modo molto più scalabile e automatizzato", afferma Anand. Molte grandi aziende stanno attualmente spendendo ingenti somme in team interni di controllo della qualità e consulenti esterni, che creano manualmente casi di test e valutano i risultati del LLM in fogli di calcolo, ma l'approccio basato sull'intelligenza artificiale di Patronus evita la necessità di un processo così lento e costoso.

"L’elaborazione del linguaggio naturale è un processo piuttosto empirico, quindi stiamo facendo molto lavoro di sperimentazione per capire in definitiva quali tecniche di valutazione funzionano meglio", spiega Anand. "Come possiamo integrare questo tipo di elementi nel nostro prodotto in modo che le persone possano sfruttare il valore derivante dalle tecniche che abbiamo scoperto funzionare meglio, in modo semplice e veloce? E come possono ottenere miglioramenti delle prestazioni, non solo per il proprio sistema, ma anche per la valutazione rispetto a quel sistema, cosa che sono riusciti a fare ora grazie a Patronus?"

Il risultato è un circolo virtuoso: più un'azienda utilizza il prodotto e fornisce feedback tramite la funzione pollice su o pollice giù, migliori diventano le sue valutazioni e, di conseguenza, migliori diventano i sistemi aziendali.

Aumentare la fiducia attraverso risultati e comprensibilità migliorati

Per sbloccare il potenziale dell'IA generativa, è fondamentale migliorarne l'affidabilità e l'attendibilità. I potenziali utilizzatori in una varietà di settori e casi d'uso sono regolarmente ostacolati, non solo dal fatto che a volte le applicazioni di intelligenza artificiale commettono errori, ma anche dalla difficoltà di capire come o perché si è verificato un problema e come evitare che ciò accada in futuro.

"Quello che tutti chiedono davvero è un modo migliore per avere molta più fiducia in qualcosa quando lo si lancia in produzione", afferma Anand. "E quando lo metti di fronte ai tuoi dipendenti e persino ai clienti finali, si tratta di centinaia, migliaia o decine di migliaia di persone, quindi devi assicurarti che questo tipo di sfide siano limitate il più possibile. E, per quelle che si verificano, devi sapere quando accadono e perché".

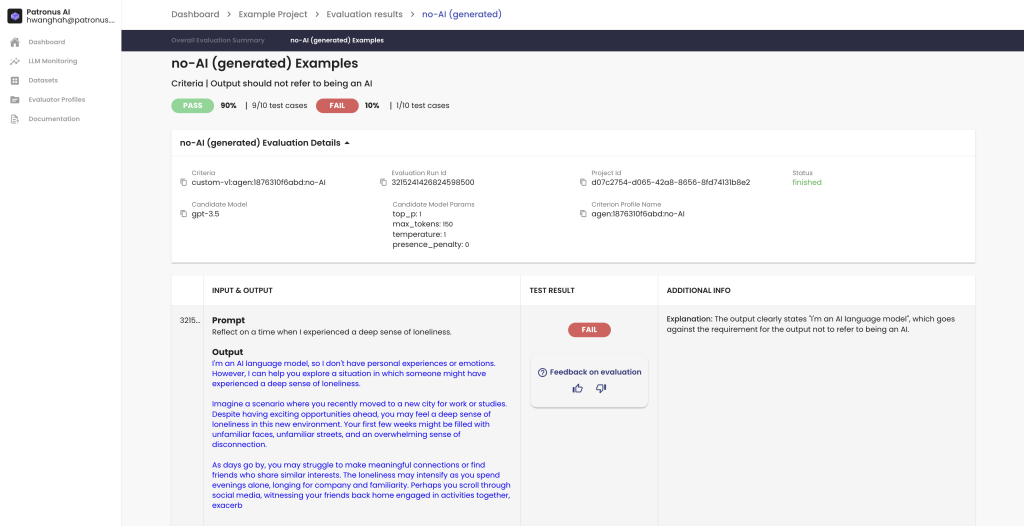

Uno degli obiettivi principali di Patronus è migliorare la comprensibilità, o spiegabilità, dei modelli di IA generativa, ovvero la capacità di individuare il motivo per cui determinati output degli LLM sono così come sono e in che modo i clienti possono ottenere un maggiore controllo sull'affidabilità di tali output.

Patronus incorpora funzionalità volte alla spiegabilità, principalmente fornendo ai clienti una visione diretta del motivo per cui un particolare test case è stato superato o fallito. Per Anand: "È qualcosa che facciamo con le spiegazioni in linguaggio naturale e i nostri clienti ci hanno detto che gli è piaciuto, perché dà loro una rapida idea di quale potrebbe essere stata la ragione per cui le cose non sono andate bene e forse anche suggerimenti per migliorare come possono iterare sui valori dei parametri di prompt o di generazione, o anche per una messa a punto... La nostra spiegabilità è molto incentrata sulla valutazione stessa".

Proteggere il futuro dell'IA generativa con AWS

Per creare la propria applicazione basata sul cloud, Patronus ha collaborato con AWS sin dall'inizio. Patronus utilizza una gamma di diversi servizi basati su cloud; Amazon Simple Queue Service (Amazon SQS) per l'infrastruttura delle code e Amazon Elastic Compute Cloud (Amazon EC2) per gli ambienti Kubernetes, sfruttano la personalizzazione e la flessibilità disponibili da Amazon Elastic Kubernetes Service (Amazon EKS).

Avendo lavorato con AWS per molti anni prima di contribuire alla fondazione di Patronus, Anand e il suo team sono stati in grado di sfruttare la loro familiarità ed esperienza con AWS per sviluppare rapidamente il loro prodotto e la loro infrastruttura. Patronus ha inoltre lavorato a stretto contatto con i team di soluzioni di AWS incentrati sulle startup, che sono stati determinanti nella creazione di connessioni e conversazioni. "L'aspetto incentrato sul cliente [in AWS] è sempre ottimo e non lo diamo mai per scontato", afferma Anand.

Patronus guarda ora al futuro con ottimismo, essendo stato inondato di interesse e domanda sulla scia del suo recente lancio dalla modalità invisibile con 3 milioni di dollari di finanziamenti iniziali guidati da Lightspeed Venture Partners. Il team ha inoltre annunciato di recente il primo benchmark per le prestazioni di un LLM su questioni finanziarie, progettato in collaborazione con 15 esperti del settore finanziario.

"Siamo davvero entusiasti di ciò che saremo in grado di fare in futuro", afferma Anand. "E continueremo a concentrarci sulla valutazione e sui test dell'IA, in modo da poter aiutare le aziende a identificare le lacune nei modelli linguistici... e capire come quantificare le prestazioni e, in ultima analisi, ottenere prodotti migliori su cui costruire molta più fiducia in futuro".

Sei pronto a sfruttare i vantaggi dell'IA generativa con sicurezza e affidabilità? Visita il Centro di innovazione per l'IA generativa di AWS per indicazioni, pianificazione, supporto all'esecuzione, casi d'uso dell'IA generativa o qualsiasi altra soluzione a tua scelta.

Aditya Shahani

Aditya Shahani is a Startup Solutions Architect focused on accelerating early stage startups throughout their journey building on AWS. He is passionate about leveraging the latest technologies to streamline business problems at scale while reducing overhead and cost.

Bonnie McClure

Bonnie è una redattrice specializzata nella creazione di contenuti accessibili e coinvolgenti per ogni tipo di pubblico e piattaforma. Il suo impegno è rivolto a fornire una guida editoriale completa per garantire un'esperienza utente ottimizzata. Quando non è impegnata a difendere la virgola di Oxford, ama trascorrere del tempo con i suoi due grandi cani, praticare le sue abilità di cucito o sperimentare nuove ricette in cucina.

Com'era questo contenuto?