Com'era questo contenuto?

- Scopri

- Il gestore di portafoglio basato sull'IA generativa di Boosted.ai fornisce informazioni finanziarie quasi istantanee con AWS

Il gestore di portafoglio basato sull'IA generativa di Boosted.ai fornisce informazioni finanziarie quasi istantanee con AWS

Passando da un LLM generico troppo esteso e ingombrante per le loro esigenze a un modello su misura per il loro dominio (mercati dei capitali), Boosted.ai ha ridotto i costi del 90%, migliorato notevolmente l'efficienza e sbloccato la capacità GPU necessaria per scalare la propria applicazione di gestione degli investimenti basata sull'IA generativa.

Riepilogo

Nel 2020, Boosted.ai ha ampliato la propria piattaforma di analisi finanziaria basata sull'intelligenza artificiale (IA), Boosted Insights, creando un assistente di portafoglio IA per i gestori patrimoniali su un modello linguistico di grandi dimensioni (LLM) che ha elaborato dati provenienti da 150.000 fonti. Il risultato sono stati approfondimenti macroeconomici e analisi delle tendenze di mercato su oltre 60.000 titoli in tutti i mercati azionari globali (Nord America, UE e Regno Unito, APAC, Medio Oriente, America Latina e India). Tuttavia, l'utilizzo di un LLM presentava alcuni svantaggi significativi: un costo operativo annuo elevato e limitazioni della capacità delle GPU che ne limitavano la scalabilità.

Boosted.ai ha iniziato l'ottimizzazione del dominio di un modello in esecuzione su AWS e:

- ha ridotto i costi del 90% senza sacrificare la qualità

- è passata da aggiornamenti notturni a aggiornamenti quasi in tempo reale, sbloccando più valore per i loro clienti gestori di investimenti che agiscono su centinaia di migliaia di origini dati

- ha migliorato sicurezza e personalizzazione con la possibilità di eseguire un modello nel cloud privato di un cliente, anziché eseguire carichi di lavoro tramite un cloud LLM

Introduzione

Il 2023 è stato l'anno in cui l'IA generativa è diventata mainstream. Migliorare l'efficienza per fare di più con meno continuerà a far parte delle agende aziendali per tutto il 2024 e oltre. È fondamentale che i team dispongano di una strategia su come incorporare l'IA generativa per aumentare la produttività. Tuttavia, anche quando c'è un chiaro caso d'uso, non è sempre evidente come implementare l'IA generativa in un modo che abbia senso per i profitti di un'azienda.

Ecco come Boosted.ai ha incorporato l'IA generativa per automatizzare le attività di ricerca per i propri clienti di gestione degli investimenti in modo da migliorare i risultati sia per Boosted.ai che per i suoi clienti.

Fondata nel 2017, Boosted.ai offre una piattaforma di intelligenza artificiale e machine learning (ML), Boosted Insights, per aiutare i gestori patrimoniali a selezionare i dati per migliorare la loro efficienza, migliorare le metriche del portafoglio e prendere decisioni migliori basate sui dati. Quando i fondatori hanno visto l'impatto di potenti LLM, hanno deciso di utilizzare un LLM closed-source per creare un assistente per la gestione del portafoglio basato sull'intelligenza artificiale. Da un giorno all'altro, elaborerebbe milioni di documenti provenienti da 150.000 fonti, inclusi set di dati non tradizionali come archivi SEC come 10K e 10Q, previsioni finanziarie, pubblicazioni commerciali, notizie internazionali, notizie locali e persino moda. Dopotutto, se si parla di un'azienda come Shein che viene quotata in borsa, un articolo di Vogue potrebbe diventare un'informazione rilevante per gli investimenti. Boosted Insights ha riassunto e raccolto tutte queste informazioni in un'interfaccia utente interattiva che i clienti gestori patrimoniali potevano organizzare da soli.

Con il suo nuovo modello di IA generativa, Boosted.ai stava ora inviando informazioni critiche sugli investimenti a tutti i suoi clienti, oltre 180 dei maggiori gestori patrimoniali del mondo. Per questi team, il tempo è denaro. Quando qualcosa influisce sul prezzo delle azioni di una società, la velocità con cui qualcuno ottiene tali informazioni e agisce in base ad esse può fare la differenza di migliaia, persino milioni di dollari. Boosted.ai ha dato un vantaggio a questi manager. Ad esempio, ha segnalato che Apple stava trasferendo alcune delle sue capacità produttive in India prima che arrivasse la notizia nei principali media, perché Boosted Insights stava leggendo articoli sui media indiani.

L'aggiunta di una componente di IA generativa a Boosted Insights ha automatizzato gran parte della ricerca per trasformare un'ipotesi di investimento in un'operazione effettiva. Ad esempio, se un investitore fosse preoccupato per una guerra commerciale con la Cina, potrebbe chiedere a Boosted Insights: «Quali sono i tipi di azioni che dovrei acquistare o vendere?» Prima dell'IA generativa, rispondere a questa domanda richiedeva un processo di ricerca di 40 ore, passando al setaccio centinaia di pagine di report degli analisti, articoli di notizie e riepiloghi degli utili. Con un assistente per la gestione del portafoglio basato sull'intelligenza artificiale, l'80% di quel lavoro è stato ora automatizzato.

Soluzione scalabile con modelli linguistici specifici del dominio

L'implementazione dell'IA generativa di Boosted.ai è stata accolta molto bene dai clienti, ma l'azienda voleva scalarla per eseguire fino a 5 o 10 volte più analisi e passare dai report notturni a un vero sistema in tempo reale. Ma c'era un problema: l'utilizzo dell'IA costava quasi 1 milione di dollari all'anno in commissioni e, anche se volevano acquistare una maggiore capacità della GPU, semplicemente l'azienda non poteva farlo: non c'era abbastanza capacità GPU perché il loro strumento di analisi finanziaria AI potesse scalare in un'applicazione in tempo reale.

Dimensionamento corretto del modello per ridurre i costi e aumentare la scalabilità

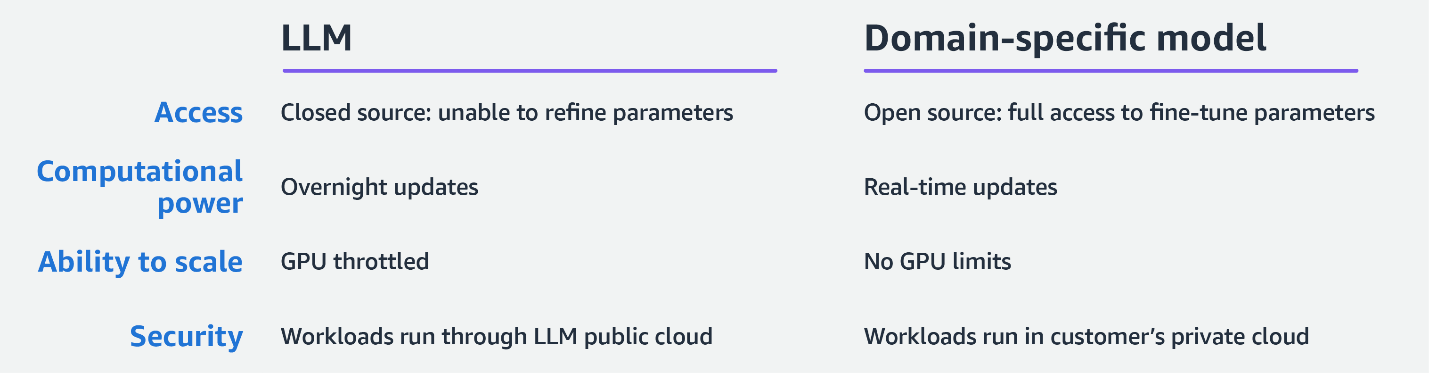

Le sfide di Boosted.ai sono sempre più comuni per le organizzazioni che adottano LLM e IA generativa. Poiché gli LLM sono addestrati per un uso generico, le aziende che addestrano questi modelli dedicano molto tempo, test e denaro per farli funzionare. Più grande è il modello, maggiore è la velocità di calcolo che deve utilizzare per ogni richiesta. Di conseguenza, per la maggior parte delle organizzazioni, incluso Boosted.ai, non è possibile utilizzare un LLM per un'attività specifica.

Boosted.ai ha deciso di esplorare un approccio più mirato ed economico: mettere a punto un modello linguistico più piccolo per eseguire un'attività specifica. Nel mondo dell'IA/ML, questi modelli vengono spesso definiti «open source», ma ciò non significa che vengano messi insieme da persone a caso che condividono un wiki, come si può immaginare fin dagli albori della codifica open source. Invece, i modelli di linguaggio open source, come Llama 2 di Meta, sono addestrati su trilioni di punti dati e gestiti in ambienti sicuri come Amazon Bedrock. La differenza è che un modello open source offre agli utenti l'accesso totale ai suoi parametri e la possibilità di ottimizzarli per attività specifiche. Gli LLM closed-source, al contrario, sono una scatola nera che non consente il tipo di personalizzazione necessario di cui Boosted.ai ha bisogno per creare.

La capacità di ottimizzare il suo modello si rivelerebbe fondamentale per Boosted.ai. Tramite la rete di partner AWS, Boosted.ai si è connessa con Invisible, la cui rete globale di specialisti di formazione sull'intelligenza artificiale ha permesso a Boosted.ai di concentrarsi sul proprio lavoro di sviluppo principale, mentre Invisible ha fornito annotazioni di dati di alta qualità in modo più rapido ed economico rispetto all'impiego di personale interno per il progetto. Insieme, AWS, Invisible e Boosted.ai hanno trovato e implementato il modello più piccolo possibile in grado di gestire il loro caso d'uso, confrontando il set di dati Massive Multitask Language Understanding (MMLU) standard del settore per valutare le prestazioni.

«Il nostro obiettivo era avere il modello più piccolo possibile con il più alto quoziente intellettivo possibile per le nostre attività. Siamo entrati nel MMLU e abbiamo esaminato le sottoattività che ritenevamo altamente pertinenti con ciò che Boosted.ai sta facendo: microeconomia e macroeconomia, matematica e altro. Abbiamo preso il modello più piccolo che pensavamo potesse funzionare e lo abbiamo ottimizzato per renderlo il migliore possibile per le nostre attività. Se ciò non avesse funzionato, saremmo passati al modello di dimensioni successive e al livello di intelligenza successivo».– Joshua Pantony, Boosted.ai co-founder and CEO

Con un modello più compatto ed efficiente che ha funzionato altrettanto bene nell'analisi finanziaria, Boosted.ai ha ridotto i costi del 90%. Il grande vantaggio che ha tratto da questa efficienza è stato la possibilità di aumentare notevolmente la quantità di dati raccolti, passando da aggiornamenti istantanei a quasi in tempo reale. Ancora più importante, Boosted.ai ha ottenuto le GPU di cui aveva bisogno per scalare. Laddove una volta Boosted.ai aveva bisogno di A100 e H100 per eseguire i propri modelli, questa IA generativa specifica per dominio più efficiente consentiva loro di eseguire uno strato su hardware più piccolo e più facilmente disponibile.

Maggiore sicurezza e personalizzazione con un modello più piccolo

Avendo messo a punto un modello più piccolo con la stessa efficacia, Boosted.ai aveva la capacità di calcolo per eseguire ancora più analisi. Ora, invece di elaborare i dati durante le ore notturne, poteva elaborarli ogni minuto e promettere ai clienti un ritardo di soli 5-10 minuti tra l'evento e il rilevamento da parte di Boosted Insights.

Il modello ha inoltre fornito a Boosted.ai una maggiore possibilità di scegliere dove e come implementarlo. Con un LLM, Boosted.ai inviava il carico di lavoro a un cloud closed-source, recuperava i risultati e quindi li archiviava. Ora l'azienda può implementarlo all'interno del cloud privato virtuale (VPC) di un altro cliente su AWS per una maggiore sicurezza.

«Avere una strategia di IA generativa sarà un'aspettativa fondamentale per le società di gestione degli investimenti nel 2024 e stiamo assistendo a un'enorme domanda di aziende che vogliono gestire i propri dati interni attraverso la nostra IA generativa per creare agenti intelligenti. Comprensibilmente, l'utilizzo di dati proprietari solleva problemi di privacy. Molti dei nostri utenti si sentono più sicuri con il nostro modello rispetto a un grande LLM closed-source. Il 90% dei nostri clienti ha un account AWS e il vantaggio che stiamo riscontrando è che proteggere i propri dati all'interno del proprio cloud privato AWS è estremamente semplice se eseguito sullo stesso cloud».

«Dare accesso a implementazioni private che gestiscono i propri dati è molto più semplice che cercare di creare il tutto da zero».– Joshua Pantony

Con la maggiore tranquillità offerta da un endpoint privato, sempre più clienti sono disposti a condividere i propri dati proprietari per creare approfondimenti più personalizzati. Ad esempio, un hedge fund potrebbe avere accesso a interviste con centinaia di CFO e analisti di gestione. Questo set di dati è troppo prezioso e riservato per essere inviato a un endpoint API pubblico. Con l'approccio specifico per dominio di Boosted.ai, ciò non è necessario. L'intero carico di lavoro viene eseguito all'interno del cloud del cliente, che ottiene informazioni più personalizzate.

Il futuro: modelli linguistici specifici per dominio e un nuovo modo di attingere alle competenze

Man mano che il modello linguistico più piccolo ottimizzato di Boosted.ai cresce, le informazioni che offre diventeranno più nitide e quantificate. Ad esempio, oggi può indicare quali aziende sono state colpite da un evento, come la guerra in Ucraina. In futuro, sarà in grado di quantificare tale effetto e dire: «Esattamente il 7% delle entrate di questa società ne risentirà, ed ecco la probabilità di come sarà influenzata».

Inoltre, ottenere tali informazioni richiederà una minore interazione da parte dell'utente. Sarà possibile caricare le tue competenze e conoscenze sulla tua intelligenza artificiale personalizzata, farle scansionare un vasto database di informazioni e inviarti idee uniche.

L'intelligenza artificiale è la tecnologia adottata più rapidamente nella storia dell'umanità e, per le organizzazioni più piccole, i casi d'uso all'avanguardia di oggi saranno probabilmente la norma nel giro di pochi anni.

«Viviamo in un momento storico davvero unico, in cui ci sono molte grandi aziende che non conoscono il potenziale di questa tecnologia e la stanno adottando in modi non ottimali. Vediamo un sacco di chatbot a sinistra, a destra e al centro. Se oggi sei una startup, incontra i tuoi clienti, scopri i loro problemi e sii consapevole di cosa è capace l'IA generativa. Se lo fai, c'è un'alta probabilità che troverai un valore aggiunto unico».

«Una volta che sarai sicuro di avere un prodotto adatto al mercato, penserei a mettere a punto i modelli più piccoli rispetto agli LLM in termini di velocità, precisione e sensibilità dei dati. Se ritieni che uno di questi sia fondamentale per il tuo caso d'uso, probabilmente vale la pena utilizzare un modello specifico per il dominio».– Joshua Pantony

Un ulteriore ringraziamento a Invisible per il suo contributo a questo progetto e articolo. Invisible è una società di innovazione operativa che unisce perfettamente intelligenza artificiale e automazione con una forza lavoro umana qualificata per sbloccare i colli di bottiglia nell'esecuzione strategica.

Ryan Masciovecchio

Ryan is a Solutions Architect at AWS living in Toronto, Canada. He provides technical advice to startups, allowing them to build innovative products using emerging technologies. Ryan has over 15 years of experience, from racking servers and configuring networking appliances to building infrastructure for web applications using cloud services. Ryan enjoys learning how technology can be used in creative ways to simplify people’s lives.

Deepam Mishra

Deepam Mishra is a Sr Advisor to Startups at AWS and advises startups on ML, Generative AI, and AI Safety and Responsibility. Before joining AWS, Deepam co-founded and led an AI business at Microsoft Corporation. Deepam has been a serial entrepreneur and investor, having founded 4 AI/ML startups in areas such as security, enterprise software and healthcare. He was the VP of New Ventures at Wipro Technologies and co-founded Venture Studio, a startup incubator, and seed-fund. He has created multiple successful startups, including SightLogix, EyeIC, Green-Power-Systems, Shippr, and more. Deepam has a BSEE from IIT Kanpur, an MSEE from Texas A&M, and an MBA from The Wharton School. He has 5 US patents and numerous publications. He is based in the Silicon Valley.

Joshua Pantony

Josh is a co-founder and CEO of Boosted.ai, an AI company that brings advanced ML tools to institutional investors and wealth managers. Since starting Boosted.ai in 2017, the company has helped hundreds of investment managers implement machine learning in their portfolios. Prior to founding Boosted.ai, Josh was a Principal ML engineer at Bloomberg for 4 years. At Bloomberg, he helped start and build numerous critical ML initiatives including Ranking, Recommendation, Question and Answering, Crowd Sourcing, and Knowledge Graphs. He also acted as a consultant on numerous initiatives across the company and helped build several ML teams. As a student at the University of Waterloo, Josh co-founded his first company, Maluuba, a deep learning natural language processing company. At Maluuba, he built the earliest prototype, recruited the entire ML team, and oversaw general technology development from 4 people up to a 30 person company. He has 8 patents to his name all of which are core Maluuba IP. Maluuba was later bought by Microsoft.

Com'era questo contenuto?