Qu’est-ce que le RLHF ?

L’apprentissage par renforcement à partir du feedback humain (RLHF) est une technique de machine learning (ML) qui utilise le feedback humain pour optimiser les modèles ML afin d’améliorer l’efficacité de l’autoapprentissage. Les techniques d’apprentissage par renforcement (RL) entraînent les logiciels à prendre des décisions qui maximisent les récompenses et rendent leurs résultats plus précis. Le RLHF intègre le feedback humain dans la fonction de récompenses, afin que le modèle ML puisse effectuer des tâches plus en phase avec les objectifs, les souhaits et les besoins humains. Le RLHF est utilisé dans toutes les applications d’intelligence artificielle générative (IA générative), y compris dans les grands modèles de langage (LLM).

En savoir plus sur le machine learning

En savoir plus sur l’apprentissage par renforcement

Pourquoi le RLHF est-il important ?

Les applications de l’intelligence artificielle (IA) sont très variées, allant des voitures autonomes au traitement du langage naturel (NLP), en passant par les prédicteurs boursiers et les services de personnalisation du commerce de détail. Quelle que soit l’application, l’objectif de l’IA est en fin de compte d’imiter les réponses, les comportements et les prises de décision humains. Le modèle ML doit coder les données humaines sous forme de données d’entraînement afin que l’IA imite plus fidèlement les humains lors de l’exécution de tâches complexes.

Le RLHF est une technique spécifique utilisée pour entraîner les systèmes d’IA à paraître plus humains, parallèlement à d’autres techniques telles que l’apprentissage supervisé et non supervisé. Tout d’abord, les réponses du modèle sont comparées à celles d’un humain. Ensuite, un humain évalue la qualité des différentes réponses de la machine, en notant les réponses qui semblent les plus humaines. Le score peut être basé sur des qualités intrinsèquement humaines, telles que la convivialité, le bon degré de contextualisation et l’humeur.

Le RLHF joue un rôle important dans la compréhension du langage naturel, mais il est également utilisé dans d’autres applications d’IA générative.

En savoir plus sur l’intelligence artificielle

En savoir plus sur le traitement du langage naturel

En savoir plus sur la différence entre l’apprentissage supervisé et non supervisé

Améliore les performances de l’IA

Le RLHF rend le modèle ML plus précis. Des modèles peuvent être entraînés sur des données humaines prégénérées, mais le fait de disposer de boucles de commentaires humains supplémentaires améliore considérablement les performances du modèle par rapport à son état initial.

Par exemple, lorsqu’un texte est traduit d’une langue vers une autre, un modèle peut produire un texte techniquement correct, mais qui ne semble pas naturel au lecteur. Un traducteur professionnel peut d’abord effectuer la traduction, la traduction générée par machine étant notée en fonction de celle-ci, puis une série de traductions générées par machine peut être notée en fonction de la qualité. L’ajout d’un entraînement supplémentaire au modèle lui permet de mieux produire des traductions à consonance naturelle.

Introduit des paramètres d’entraînement complexes

Dans certains cas, en IA générative, il peut être difficile d’entraîner avec précision le modèle pour certains paramètres. Par exemple, comment définissez-vous l’ambiance d’un morceau de musique ? Certains paramètres techniques tels que la tonalité et le tempo peuvent indiquer une certaine ambiance, mais l’esprit d’une pièce musicale est plus subjectif et moins bien défini qu’une simple série de détails techniques. Au lieu de cela, vous pouvez fournir des conseils humains lorsque les compositeurs créent des pièces de mauvaise humeur, puis vous pouvez étiqueter les pièces générées par des machines en fonction de leur niveau de mauvaise humeur. Cela permet à une machine d’apprendre ces paramètres beaucoup plus rapidement.

Améliore la satisfaction des utilisateurs

Bien qu’un modèle ML puisse être précis, il peut ne pas sembler humain. Le RL est nécessaire pour orienter le modèle vers la réponse la meilleure et la plus engageante pour les utilisateurs humains.

Par exemple, si vous demandez à un chatbot quel temps il fait à l’extérieur, il pourrait répondre : « Il fait 30 degrés Celsius avec des nuages et une humidité élevée » ou « La température est d’environ 30 degrés en ce moment. Le temps est nuageux et humide, donc l’air peut sembler plus épais.» Bien que les deux réponses disent la même chose, la deuxième réponse semble plus naturelle et fournit plus de contexte.

Au fur et à mesure que les utilisateurs humains évaluent les réponses de modèle qu’ils préfèrent, vous pouvez utiliser le RLHF pour recueillir des commentaires humains et améliorer votre modèle afin de mieux répondre aux besoins de personnes réelles.

Comment fonctionne le RLHF ?

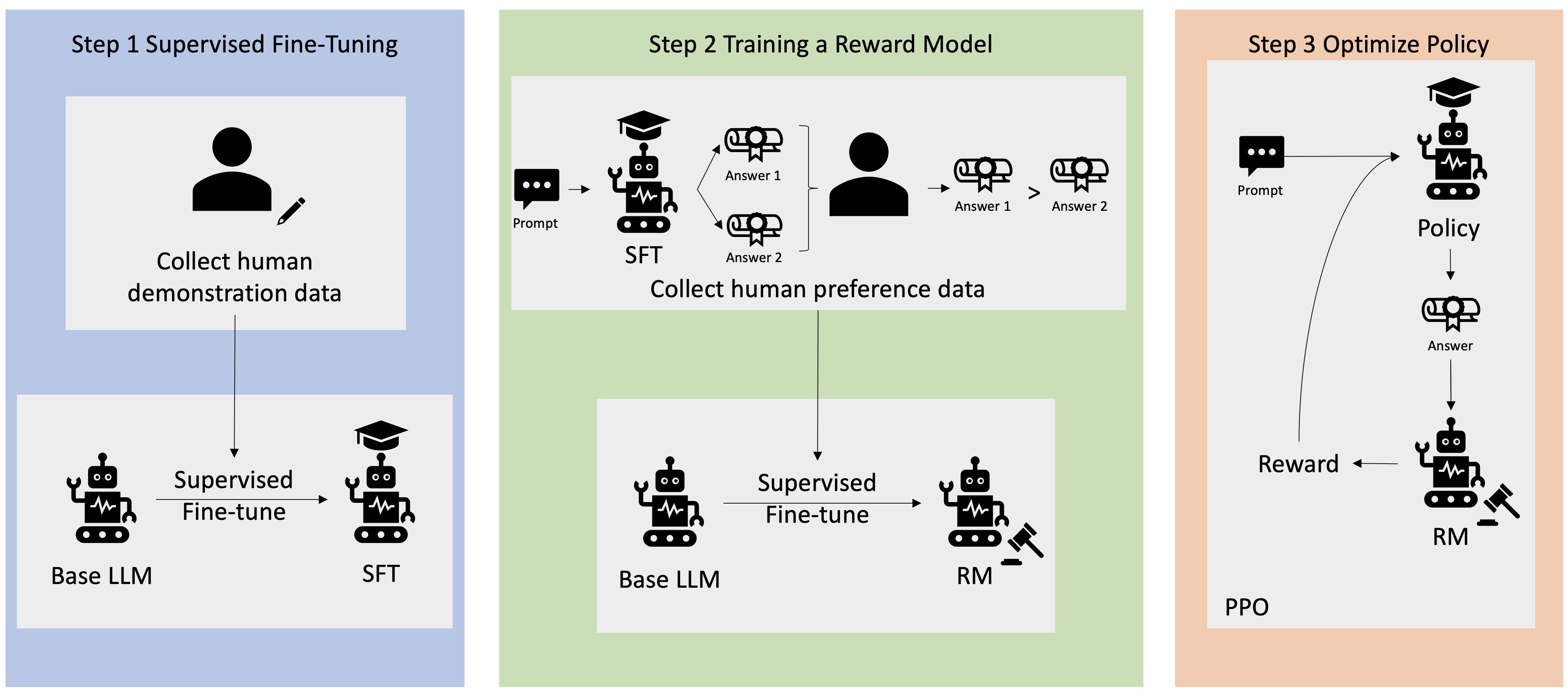

Le RLHF est réalisé en quatre étapes avant que le modèle ne soit considéré comme prêt. Nous utilisons ici l’exemple d’un modèle de langage, un chatbot interne à la base de connaissances de l’entreprise, qui utilise le RLHF pour le raffinement.

Nous ne donnons qu’un aperçu du processus d’apprentissage. L’entraînement du modèle et l’affinement de sa politique pour le RLHF présentent une complexité mathématique importante. Cependant, les processus complexes sont bien définis dans le RLHF et comportent souvent des algorithmes prédéfinis qui nécessitent simplement vos entrées uniques.

Collecte de données

Avant d’effectuer des tâches de machine learning avec le modèle de langage, un ensemble d’invites et de réponses générées par l’homme est créé pour les données d’entraînement. Cet ensemble est utilisé ultérieurement dans le processus d’entraînement du modèle.

Par exemple, les instructions peuvent être les suivantes :

- « Où se trouve le département des ressources humaines à Boston ? »

- « Quel est le processus d’approbation des publications sur les réseaux sociaux ?»

- « Qu’indique le rapport du premier trimestre sur les ventes en comparaison avec les rapports trimestriels précédents ?»

Un travailleur du savoir de l’entreprise répond ensuite à ces questions avec des réponses précises et naturelles.

Ajustement supervisé d’un modèle de langage

Vous pouvez utiliser un modèle préentraîné commercial comme modèle de base pour le RLHF. Vous pouvez affiner le modèle en fonction de la base de connaissances interne de l’entreprise à l’aide de techniques telles que la génération augmentée de récupération (RAG). Lorsque le modèle est affiné, vous comparez sa réponse aux instructions prédéterminées avec les réponses humaines collectées à l’étape précédente. Les techniques mathématiques permettent de calculer le degré de similitude entre les deux.

Par exemple, les réponses générées par machine peuvent se voir attribuer un score compris entre 0 et 1, 1 étant la plus précise et 0 la moins précise. Avec ces scores, le modèle dispose désormais d’une politique conçue pour former des réponses dont les scores sont plus proches des réponses humaines. Cette politique constitue la base de toute prise de décision future concernant le modèle.

Création d’un modèle de récompense distinct

Le cœur du RLHF réside dans l’entraînement d’un modèle de récompense IA distinct basé sur des commentaires humains, puis d’utiliser ce modèle comme fonction de récompense pour optimiser la politique grâce au RL. Étant donné un ensemble de réponses multiples du modèle répondant à la même invite, les humains peuvent indiquer leurs préférences concernant la qualité de chaque réponse. Vous utilisez ces préférences d’évaluation des réponses pour créer le modèle de récompense qui estime automatiquement le score qu’un humain obtiendrait pour une réponse rapide donnée.

Optimisation du modèle de langage avec le modèle basé sur les récompenses

Le modèle de langage utilise ensuite le modèle de récompense pour affiner automatiquement sa politique avant de répondre aux demandes. À l’aide du modèle de récompense, le modèle de langage évalue en interne une série de réponses, puis choisit la réponse la plus susceptible d’entraîner la plus grande récompense. Cela signifie qu’il répond aux préférences humaines de manière plus optimisée.

L’image suivante montre un aperçu du processus d’apprentissage RLHF.

Comment le RLHF est-elle utilisé dans le domaine de l’IA générative ?

Le RLHF est reconnu comme la technique standard de l’industrie pour garantir que les LLM produisent un contenu véridique, inoffensif et utile. Cependant, la communication humaine est un processus subjectif et créatif, et l’utilité des résultats du LLM est profondément influencée par les valeurs et les préférences humaines. Chaque modèle est entraîné légèrement différemment et utilise différents intervenants humains, de sorte que les résultats diffèrent même entre les LLM compétitifs. La mesure dans laquelle chaque modèle implique des valeurs humaines dépend entièrement du créateur.

Les applications de RLHF s’étendent au-delà des limites des LLM à d’autres types d’IA générative. Voici quelques exemples :

- Le RLHF peut être utilisé dans la génération d’images par IA : par exemple, pour évaluer le degré de réalisme, la technicité ou l’ambiance d’une œuvre d’art.

- Dans le domaine de la génération musicale, le RLHF peut aider à créer de la musique qui correspond à certaines ambiances et bandes sonores à des activités.

- Le RLHF peut être utilisé dans un assistant vocal, rendant la voix pour qu’elle soit plus amicale, curieuse et digne de confiance.

Que peut apporter AWS pour répondre à vos besoins en matière de GPU ?

Amazon SageMaker Ground Truth propose l’ensemble le plus complet de fonctionnalités « human in-the-loop » permettant d’intégrer les commentaires humains tout au long du cycle de vie du machine learning afin d’améliorer la précision et la pertinence des modèles. Vous pouvez effectuer diverses tâches « human in-the-loop », de la génération et de l’annotation de données à la génération de modèles de récompenses, à la révision du modèle et à la personnalisation par le biais d’une offre en libre-service ou gérée par AWS.

SageMaker Ground Truth inclut un annotateur de données pour les fonctionnalités de RLHF. Vous pouvez donner des commentaires et des conseils directs sur les résultats qu’un modèle a générés en hiérarchisant, en classant ou en faisant les deux pour ses réponses aux résultats du RL. Les données, appelées données de comparaison et de classement, constituent en fait un modèle de récompense ou une fonction de récompense, qui est ensuite utilisée pour entraîner le modèle. Vous pouvez utiliser les données de comparaison et de classement pour personnaliser un modèle existant en fonction de votre cas d’utilisation ou pour affiner un modèle que vous créez à partir de zéro.

Commencez à utiliser les techniques de RLHF sur AWS en créant un compte dès aujourd’hui.

Prochaines étapes sur AWS