Was ist RLHF?

Reinforcement-Learning from Human Feedback (RLHF) ist eine Technik des Machine Learning (ML), die menschliches Feedback nutzt, um ML-Modelle so zu optimieren, dass sie effizienter selbst lernen. Reinforcement-Learning-(RL)-Techniken trainieren Software darin, Entscheidungen zu treffen, die die Belohnungen maximieren und deren Ergebnisse genauer machen. RLHF bezieht menschliches Feedback in die Belohnungsfunktion ein, sodass das ML-Modell Aufgaben ausführen kann, die besser auf die menschlichen Ziele, Wünsche und Bedürfnisse abgestimmt sind. RLHF wird in allen Anwendungen der generativen künstlichen Intelligenz (generative KI) verwendet, auch in großen Sprachmodellen (LLM).

Mehr über Machine Learning lesen

Warum ist RLHF wichtig?

Die Anwendungen der künstlichen Intelligenz (KI) sind breit gefächert und reichen von selbstfahrenden Autos über die natürliche Sprachverarbeitung (NLP) bis hin zu Börsenprädiktoren und Personalisierungsdiensten für den Einzelhandel. Unabhängig von der jeweiligen Anwendung besteht das Ziel von KI letztlich darin, menschliche Reaktionen, Verhaltensweisen und Entscheidungen nachzuahmen. Das ML-Modell muss menschliche Eingaben als Trainingsdaten kodieren, damit die KI Menschen bei der Erledigung komplexer Aufgaben genauer nachahmt.

RLHF ist eine spezielle Technik, die neben anderen Techniken wie überwachtem und unüberwachtem Lernen dazu verwendet wird, KI-Systeme so zu trainieren, dass sie menschlicher erscheinen. Zunächst werden die Reaktionen des Modells mit den Antworten eines Menschen verglichen. Dann bewertet ein Mensch die Qualität der verschiedenen Antworten der Maschine und bewertet, welche Antworten menschlicher klingen. Die Punktzahl kann auf angeborenen menschlichen Eigenschaften wie Freundlichkeit, dem richtigen Grad an Kontextualisierung und Stimmung basieren.

RLHF spielt eine herausragende Rolle beim Verstehen natürlicher Sprache, wird aber auch in anderen generativen KI-Anwendungen verwendet.

Weitere Informationen über Künstliche Intelligenz (KI)

Lesen Sie mehr über natürliche Sprachverarbeitung

Lesen Sie mehr über den Unterschied zwischen überwachtem und unüberwachtem Lernen

Verbessert die KI-Leistung

RLHF macht das ML-Modell genauer. Modelle können anhand von vorab generierten menschlichen Daten trainiert werden. Zusätzliche menschliche Feedback-Schleifen verbessern die Leistung des Modells im Vergleich zu seinem Ausgangszustand erheblich.

Wenn beispielsweise Text von einer Sprache in eine andere übersetzt wird, kann ein Modell Text erzeugen, der technisch korrekt ist, für den Leser aber unnatürlich klingt. Ein professioneller Übersetzer kann zuerst die Übersetzung durchführen, wobei die maschinell generierte Übersetzung danach bewertet wird, anschließend kann eine Reihe von maschinell generierten Übersetzungen hinsichtlich ihrer Qualität bewertet werden. Durch zusätzliche Schulungen kann das Modell besser natürlich klingende Übersetzungen erstellen.

Einführung komplexer Trainingsparameter

In einigen Fällen kann es bei generativer KI schwierig sein, das Modell für bestimmte Parameter genau zu trainieren. Wie definieren Sie zum Beispiel die Stimmung eines Musikstücks? Es mag technische Parameter wie Tonart und Tempo geben, die auf eine bestimmte Stimmung hinweisen, doch die Grundstimmung eines Musikstücks ist subjektiver und weniger gut definiert als eine bloße Abfolge technischer Fakten. Stattdessen können Sie Komponisten bei der Erstellung von stimmungsvollen Stücken menschliche Anweisungen geben, anschließend können Sie maschinell generierte Stücke entsprechend ihrem Stimmungsgrad kennzeichnen. Dadurch kann eine Maschine diese Parameter viel schneller lernen.

Erhöhung der Nutzerzufriedenheit

Ein ML-Modell kann zwar genau sein, aber nicht unbedingt menschlich wirken. RL ist erforderlich, um das Modell zu der besten und ansprechendsten Reaktion für menschliche Benutzer zu leiten.

Wenn Sie beispielsweise einen Chatbot fragen, wie das Wetter draußen ist, könnte er antworten: „Es sind 30 Grad Celsius mit Wolken und hoher Luftfeuchtigkeit“, oder er könnte antworten: „Die Temperatur liegt im Moment bei etwa 30 Grad. Draußen ist es wolkig und feucht, daher scheint die Luft dicker zu sein!“ Obwohl beide Antworten dasselbe aussagen, klingt die zweite Antwort natürlicher und bietet mehr Kontext.

Während menschliche Benutzer bewerten, welche Modellantworten sie bevorzugen, können Sie RLHF verwenden, um menschliches Feedback zu sammeln und Ihr Modell so zu verbessern, dass es echten Menschen am besten dient.

Wie funktioniert RLHF?

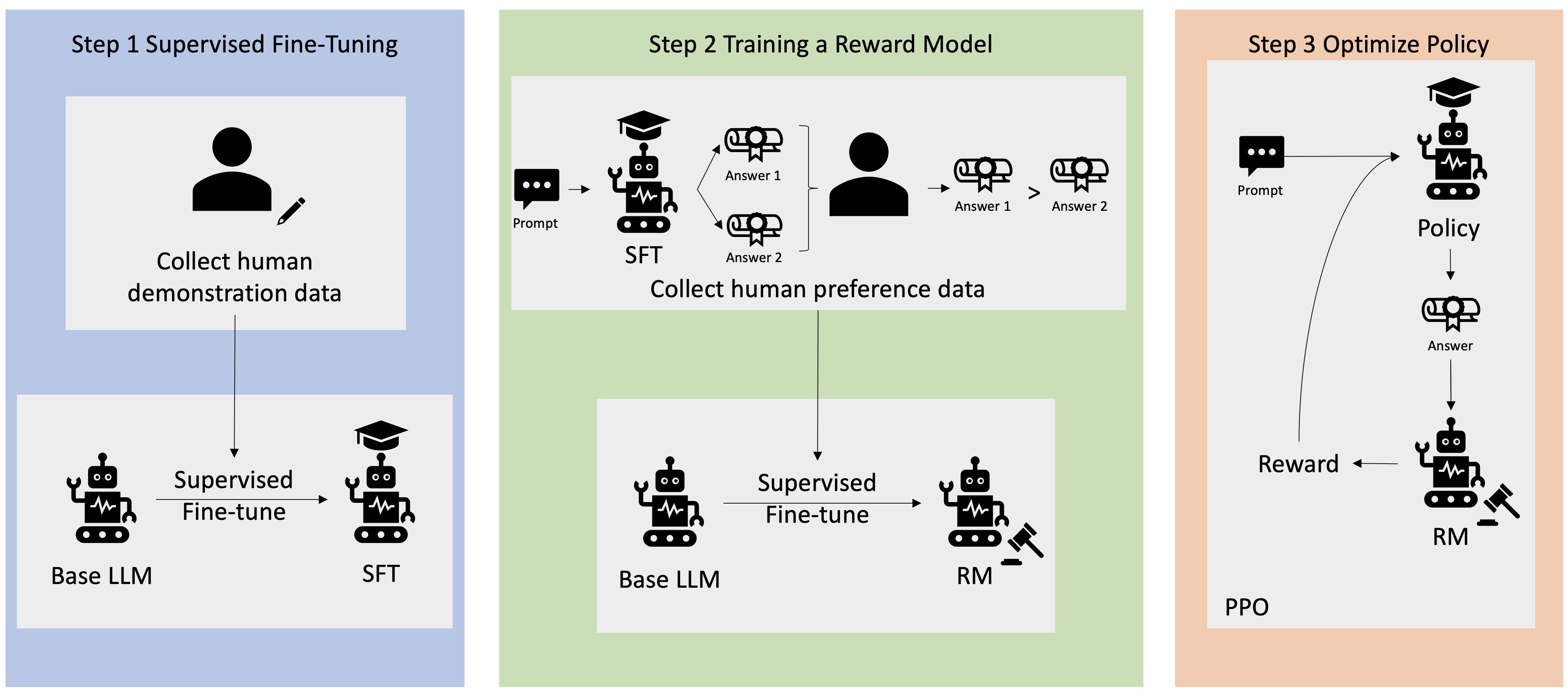

RLHF wird in vier Schritten durchgeführt, bevor das Modell als fertig betrachtet wird. Hier verwenden wir das Beispiel eines Sprachmodells – einen unternehmensinternen Chatbot für die Wissensdatenbank –, der RLHF zur Verfeinerung verwendet.

Wir geben nur einen Überblick über den Lernprozess. Beim Training des Modells und seiner politischen Verfeinerung für RLHF besteht eine erhebliche mathematische Komplexität. Die komplexen Prozesse sind jedoch in RLHF gut definiert und verfügen oft über vorgefertigte Algorithmen, die lediglich Ihre individuellen Eingaben benötigen.

Datensammlung

Bevor ML-Aufgaben mit dem Sprachmodell ausgeführt werden, wird eine Reihe von von Menschen generierten Prompts und Antworten für die Trainingsdaten erstellt. Dieses Set wird später im Trainingsprozess des Modells verwendet.

Die Prompts könnten beispielsweise lauten:

- „Wo befindet sich die Personalabteilung in Boston?“

- „Was ist das Genehmigungsverfahren für Beiträge in sozialen Netzwerken?“

- „Was sagt der Bericht für das erste Quartal über den Umsatz im Vergleich zu früheren Quartalsberichten aus?“

Ein Wissensarbeiter im Unternehmen beantwortet diese Fragen dann mit genauen, natürlichen Antworten.

Betreute Feinabstimmung eines Sprachmodells

Sie können ein kommerzielles vortrainiertes Modell als Basismodell für RLHF verwenden. Sie können das Modell mithilfe von Techniken wie Retrieval-Augmented Generation (RAG) an die interne Wissensbasis des Unternehmens anpassen. Wenn das Modell fein abgestimmt ist, vergleichen Sie seine Reaktion auf die vordefinierten Prompts mit den menschlichen Antworten, die im vorherigen Schritt erfasst wurden. Mathematische Techniken können den Grad der Ähnlichkeit zwischen den beiden berechnen.

Beispielsweise kann den maschinell generierten Antworten eine Punktzahl zwischen 0 und 1 zugewiesen werden, wobei 1 die genaueste und 0 die ungenaueste ist. Mit diesen Ergebnissen verfügt das Modell nun über eine Richtlinie, die darauf ausgelegt ist, Antworten zu formulieren, die den menschlichen Antworten näher kommen. Diese Politik bildet die Grundlage für alle zukünftigen Entscheidungen für das Modell.

Aufbau eines separaten Belohnungsmodells

Der Kern von RLHF besteht darin, ein separates KI-Belohnungsmodell zu trainieren, das auf menschlichem Feedback basiert, und dieses Modell dann als Belohnungsfunktion zu verwenden, um die Richtlinien durch RL zu optimieren. Bei einer Reihe mehrerer Antworten des Modells, die dieselbe Aufforderung beantworten, können Menschen ihre Präferenz in Bezug auf die Qualität jeder Antwort angeben. Sie verwenden diese Einstellungen für die Bewertung von Antworten, um das Belohnungsmodell zu erstellen, das automatisch schätzt, wie hoch ein Mensch bei einer bestimmten Prompt-Antwort bewerten würde.

Optimieren des Sprachmodells mit dem belohnungsbasierten Modell

Das Sprachmodell verwendet dann das Belohnungsmodell, um seine Richtlinien automatisch zu optimieren, bevor es auf Prompts reagiert. Mithilfe des Belohnungsmodells bewertet das Sprachmodell intern eine Reihe von Antworten und wählt dann die Antwort aus, die am wahrscheinlichsten zu der größten Belohnung führt. Das bedeutet, dass sie den menschlichen Vorlieben in einer optimierten Weise entspricht.

Die folgende Abbildung zeigt einen Überblick über den RLHF-Lernprozess.

Wie wird RLHF im Bereich der generativen KI eingesetzt?

RLHF ist als Industriestandardtechnik anerkannt, um sicherzustellen, dass LLMs wahrheitsgemäße, harmlose und hilfreiche Inhalte produzieren. Menschliche Kommunikation ist jedoch ein subjektiver und kreativer Prozess – und die Nützlichkeit von LLM-Ergebnissen wird stark von menschlichen Werten und Vorlieben beeinflusst. Jedes Modell wird etwas anders trainiert und verwendet unterschiedliche menschliche Antwortende, sodass sich die Ergebnisse auch zwischen kompetitiven LLMs unterscheiden. Inwieweit jedes Modell menschliche Werte beinhaltet, liegt ganz beim Urheber.

Die Anwendungen von RLHF reichen über die Grenzen von LLMs hinaus und umfassen auch andere Arten von generativer KI. Hier sind einige Beispiele:

- RLHF kann bei der KI-Bildgenerierung verwendet werden, um beispielsweise den Grad an Realismus, der technischen Ausführung oder Stimmung von Kunstwerken zu messen

- Bei der Musikgenerierung kann RLHF dabei helfen, Musik zu kreieren, die zu bestimmten Stimmungen und Soundtracks zu Aktivitäten passt

- RLHF kann in einem Sprachassistenten verwendet werden und dafür sorgen, dass die Stimme freundlicher, neugieriger und vertrauenswürdiger klingt

Wie kann AWS Ihnen bei Ihren RLHF-Anforderungen helfen?

Amazon SageMaker Ground Truth bietet den umfassendsten Satz an Human-in-the-Loop-Funktionen zur Einbeziehung von menschlichem Feedback über den gesamten ML-Lebenszyklus hinweg, um die Genauigkeit und Relevanz von Modellen zu verbessern. Sie können verschiedene Human-in-the-Loop-Aufgaben erledigen, von der Datengenerierung und -beschriftung bis hin zur Generierung von Belohnungsmodellen, Modellüberprüfung und Anpassung über ein Self-Service- oder AWS-verwaltetes Angebot.

SageMaker Ground Truth enthält einen Datenannotator für RLHF-Funktionen. Sie können direktes Feedback und Hinweise zu den Ergebnissen geben, die ein Modell generiert hat, indem Sie die Antworten für RL-Ergebnisse bewerten, klassifizieren oder beides tun. Die Daten, die als Vergleichs- und Ranking-Daten bezeichnet werden, sind quasi ein Belohnungsmodell oder eine Belohnungsfunktion, die dann zum Trainieren des Modells verwendet wird. Sie können Vergleichs- und Rangdaten verwenden, um ein vorhandenes Modell an Ihren Anwendungsfall anzupassen oder ein Modell, das Sie von Grund auf neu erstellen, zu optimieren.

Beginnen Sie mit RLHF-Techniken auf AWS, indem Sie noch heute ein Konto erstellen.

Nächste Schritte in AWS

Sie erhalten sofort Zugriff auf das kostenlose Kontingent von AWS.

Starten Sie mit der Entwicklung in der AWS-Managementkonsole.