AWS 기술 블로그

Category: Generative AI

Amazon Bedrock을 이용한 지능형 쇼핑 어시스턴트 구현하기

배경 생성형 AI가 공개된 이후로 쇼핑 경험 전환에 사용하려는 시도가 다양하게 있었습니다. 이제 단순히 상품을 검색하고 구매하는 경험을 넘어 탐색형 쇼핑으로 나아가는 과도기라고 할 수 있습니다. AI 검색을 지향하는 Perplexity에서 2024년 11월에 쇼핑 어시스턴트 기능을 출시하기도 했으며 Amazon.com에서는 Rufus를 출시했습니다. Amazon Rufus는 생성형 AI 기반 쇼핑 어시스턴트로, 고객이 상품을 검색하고, 비교하고, 추천을 받고, 구매 결정을 […]

Amazon Bedrock Agents와 MCP(Model Context Protocol) 통합하기

Amazon Bedrock의 등장 Amazon Bedrock은 업계를 선도하는 다양한 파운데이션 모델을 선택할 수 있는 완전 관리형 서비스입니다. Bedrock은 생성형 AI 기반의 애플리케이션을 구축하는 데 필요한 광범위한 기능을 제공하여 보안, 개인 정보 보호 및 책임감 있는 AI를 통해 생성형 AI 기반 애플리케이션을 개발하는데 필요한 시간을 단축시켜 줍니다. Bedrock의 포괄적인 기능을 통해 다양한 최고 수준의 파운데이션 모델을 실험하고, […]

NAB Show 2025, AWS의 최신 생성형 AI 및 라이브 클라우드 스포츠 제작 기능 선보여

“이 글은 AWS M&E Blog에 게시된 NAB Show 2025 featured latest generative AI, live cloud sports production capabilities from AWS를 한국어 번역 및 편집하였습니다.” 160개국에서 온 55,000명 이상의 미디어 및 엔터테인먼트 전문가들이 NAB Show 2025를 위해 라스베이거스에 모였습니다. 올해 행사에서 Amazon Web Services(AWS)는 새로운 혁신, 업계 발표 및 기억에 남는 순간들을 선보였습니다. 창조하고. 연결하고. 매료시키다. […]

Amazon Bedrock기반 Agentic Text-to-Image로 사용자 의도를 정확히 반영하기 (프롬프트 분해에서 검증까지)

텍스트 기반 이미지 생성의 현실적 도전과제 텍스트 기반 이미지 생성 기술(Text-to-Image)은 Nova Canvas, DALL-E, Stable Diffusion, Midjourney와 같은 인공지능 모델의 발전으로 혁신적인 변화를 가져왔습니다. 이제 사용자들은 간단한 텍스트 프롬프트만으로도 고품질의 이미지를 생성할 수 있게 되었으며, 이는 디자이너, 아티스트, 마케터 및 일반 사용자에 이르기까지 광범위한 활용 가능성을 제시하고 있습니다. 예를 들어, “일몰 시간에 해변에서 서핑하는 사람”이라는 간단한 프롬프트로 사실적인 이미지를 […]

Strands Agents와 오픈 소스 AI 에이전트 SDK 살펴보기

이 글은 AWS Open Source Blog에 게시된 Introducing Strands Agents, an Open Source AI Agents SDK 을 한국어 번역 및 편집 하였습니다. 오늘 저는 Strands Agents를 출시한다는 기쁜 소식을 전합니다. Strands Agents는 모델 중심 접근 방식으로 단 몇 줄의 코드만으로 AI 에이전트를 구축하고 실행할 수 있는 오픈 소스 SDK입니다. Strands는 간단한 사용 사례부터 복잡한 에이전트 사용 […]

Amazon Bedrock과 LangGraph로 Multi Agent 시스템 구현하기

이 글은 AWS Machine Learning Blog 에 게시된 Build multi-agent systems with LangGraph and Amazon Bedrock by Jagdeep Singh Soni, Ajeet Tewari, and Rupinder Grewal 을 한국어 번역 및 편집 하였습니다. 대규모 언어 모델(LLM)은 사용자가 자연어로 애플리케이션과 소통할 수 있다는 기대치를 높이며 인간-컴퓨터 상호작용의 수준을 한 단계 끌어올렸습니다. 단순한 언어 이해를 넘어, 실제 애플리케이션에서는 복잡한 워크플로우 관리, 외부 데이터 […]

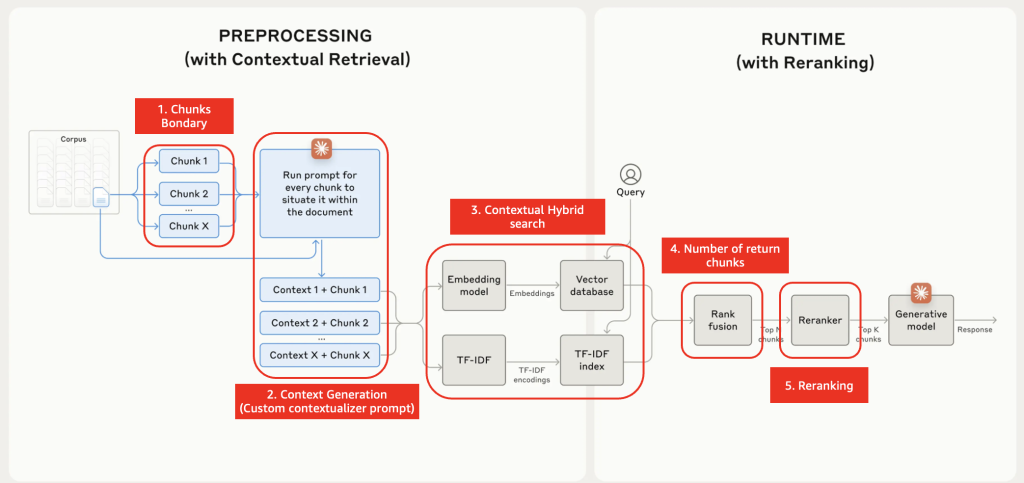

Amazon Bedrock기반에서 Contextual Retrieval 활용한 검색 성능 향상 및 실용적 구성 방안

개요 인공지능 기술의 발전과 함께 대규모 언어 모델(LLM)의 성능 향상을 위한 다양한 방법들이 연구되고 있습니다. 그 중에서도 Retrieval Augmented Generation (RAG)은 외부 지식을 활용하여 모델의 응답 능력을 크게 개선하는 주요 기술로 주목받고 있습니다. RAG는 사용자의 질문에 관련된 정보를 외부 데이터베이스에서 검색하고, 이를 프롬프트에 추가하여 더 정확하고 맥락에 맞는 응답을 생성하는 방식으로 작동합니다. 하지만 기존의 RAG […]

SF 시리즈: Amazon Bedrock 기반 IAM Policy 자동 생성 및 할당 🚀

SF 시리즈 소개 과거 공상과학(SF) 작품에서만 가능할 것 같았던 기술들이 이제는 AWS의 다양한 서비스와 기능을 통해 현실이 되고 있습니다. 이러한 혁신적인 기능들은 여러 서비스의 기능 조합과 복잡한 패턴을 필요로 하며, 이를 효과적으로 오케스트레이션할 수 있는 도구가 필수적입니다. AWS에서는 이러한 복잡한 프로세스를 손쉽게 설계하고 자동화할 수 있도록 AWS Step Functions을 제공합니다. Step Functions을 활용하면 복잡한 비즈니스 […]

AI 응답성 최적화하기: Amazon Bedrock 지연 시간 최적화 추론에 대한 실용적인 가이드

이 글은 AWS Machine Learning 블로그의 Optimizing AI responsiveness: A practical guide to Amazon Bedrock latency-optimized inference by Ishan Singh, Ankur Desai, Rupinder Grewal, Vivek Singh, and Yanyan Zhang의 한국어 번역입니다. 상용 생성형AI 애플리케이션에서 반응성은 모델의 성능(정확도)만큼이나 중요합니다. 시간에 민감한 문의 사항을 처리하는 고객 서비스 팀이든, 즉각적인 코드 제안이 필요한 개발자이든, 지연 시간(대기 시간)으로 알려진 1초의 지연도 상당한 영향을 미칠 […]

SK하이닉스의 RAG 플랫폼 구축 및 성능 평가/분석 연구 사례

이 블로그는 SK hynix 오세진 TL, 노정기 TL, 오태진 TL 이 함께 작성하였습니다. SK 하이닉스는 AI 시대라는 새로운 세상의 중심에 반도체가 있다는 사명감을 가지고 최고의 기술력을 향해 끊임없는 혁신을 이뤄 가고 있습니다. 세계 최고 성능의 HBM3를 최초 개발 및 출시한 데 이어 확장 버전인 HBM3E 역시 세계 최초 양산에 성공하며 메모리 반도체 시장을 선도하고 있고, 세계 […]